يادگيري عميق (Deep Learning) - پنجشنبه ۱۴-۸

کامپیوتر | دوره های برنامه نویسی | يادگيري عميق (Deep Learning)

60.00 ساعت

10 جلسه

پنج شنبه

08:00 الی 14:00

تاریخ پایان ثبت نام: 1403/11/04 - 23:00

فرصت باقیمانده ثبت نام:

تاریخ پایان کلاس: 1404/01/28

قیمت دوره: 6,320,000 تومان

اهداف برگزاري دوره/ كارگاه:

- گذراندن این دوره پیش نیاز شاخه های گوناگون دانش هوش مصنوعی و برنامه نویسی هوشمند می باشد.

- گذراندن این دوره منجر به طراحی و ساخت مدل های هوشمند مبتنی بر شبکه عصبی عمیق می شوند و می توانید در حوزه پردازش تصاویر آن را شخصی سازی نمود.

تواناييهاي مورد انتظار فراگيران در پايان دوره/ كارگاه:

- آشنایی با انواع Optimizer ها در شبکه های عمیق عصبی

- آشنایی با روش های مختلف مقدار دهی وزن در شبکه های عمیق عصبی

- آشنایی با انواع روش های Regularization و Augmentation جهت افزایش پیچیدگی داده ها

- آشنایی با شبکه های عمیق پیچشی و آشنایی با شبکه های عمیق بازگشتی

- آشنایی با معماری ترتیب به ترتیب (Seq to Seq) و معماری تبدیل شونده ها (Transformers)

- ساخت و پیاده سازی شبکه های عمیق بر اساس معماری Auto Encoder و آشنایی با معماری Variational Auto Encoder

- آشنایی با شبکه های عمیق Generative به همراه معماری های مطرح آن

زمينههاي اشتغال زايي دوره/ كارگاه:

- فعالیت در حوزه هایی همچون تولید دستیار هوشمند

- حوزه پردازش متن

- حوزه پردازش هوشمند تصاویر

- ساخت مدل های هوشمند برای توصیف و ارزیابی پدیده های پیچیده

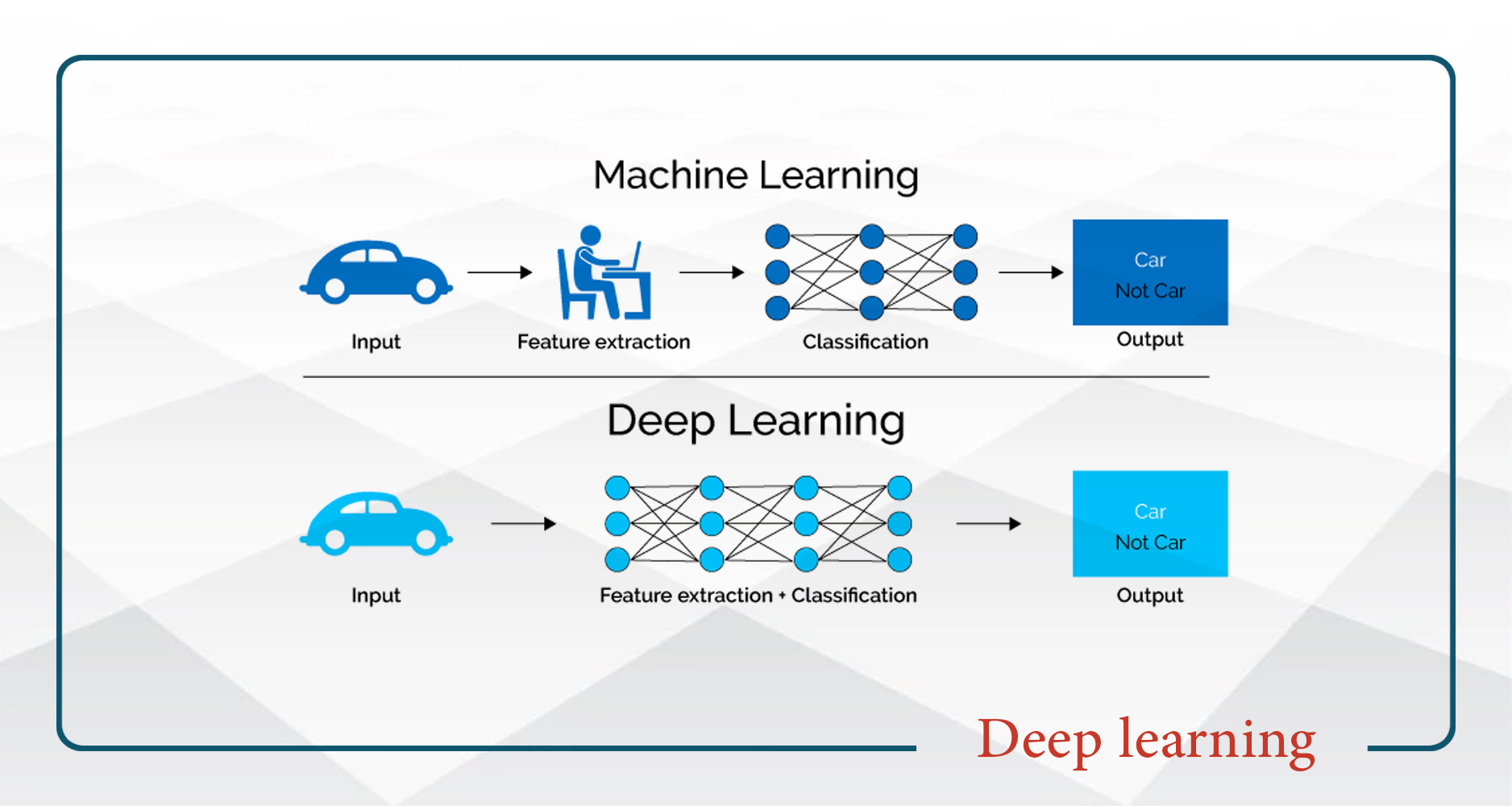

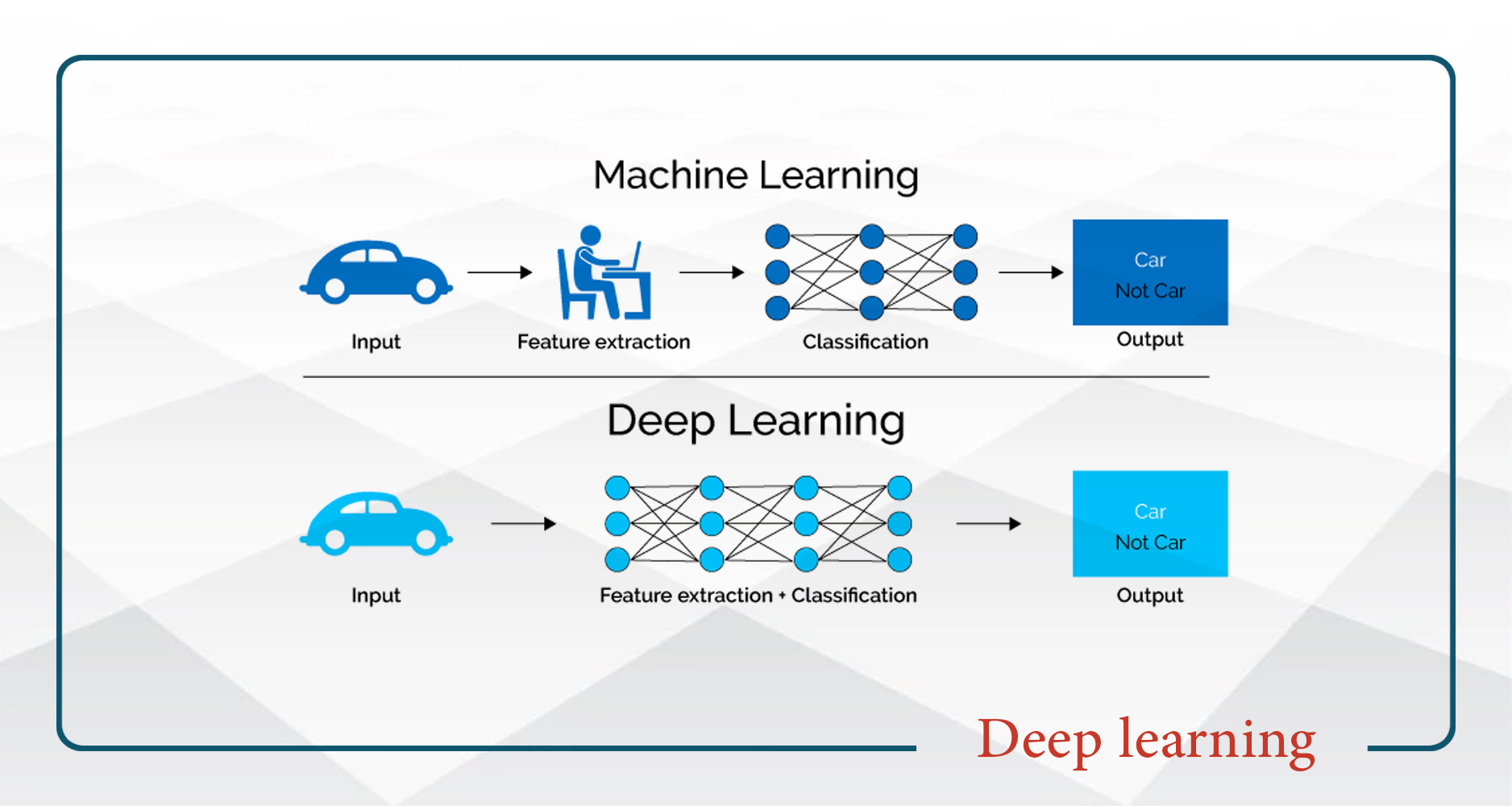

فصل اول: مروری بر یادگیری ماشین و شبکه های عصبی

مروری بر انواع توابع آتش

مروری بر نحوه محاسبه گرادیان و انواع توابع خطا

مروری بر روال کلی backpropagation

مروری بر روال های دسته بندی و رگرسیون

مروری بر روال آموزش شبکه های عصبی در تنسورفلو و کراس

فصل دوم:

انواع Optimizationها در محاسبه گرادیان شبکه های عصبی

آپدیت وزن شبکه از طریق Random search

بررسی روش های ساده محاسبه گرادیان:

گرادیان چیست

Gradient Descent

Mini-batch Gradient Descent

Stochastic Gradient

Stochastic Gradient Descent

بررسی مفهوم Moving Average

Momentum

Nesterov Momentum

محاسبه گرادیان از طریق AdaGrad

محاسبه گرادیان از طریق RMSProp

محاسبه گرادیان از طریق Adam

فصل سوم:

مقدمات شبکه های عصبی عمیق

Data preprocessing

مروری بر PCA و روش های کاهش بعد

Weight Initialization

Random

Xavier

HE

Batch Normalization

Hyperparameter Optimization

بررسی روال تغییرات learning rate

Monitor and visualize the accuracy

Monitor and visualize the loss

Regularization

L1 / L2 regularization

Dropout

Data Augmentation

فصل چهارم:

شبکه های عمیق پیچشی Convolutional Neural Network

بیان ساختار کلی شبکه های عصبی پیچشی

معرفی لایه های مختلف شبکه های CNN

لایه Fully connected

لایه Convolutional

لایه Polling

لایه Softmax

آشنایی با مفاهیم dim و Stride و padding

معرفی معماری های مختلف شبکه های CNN

Alexnet

VGG

GoogleNet

ResNet

پیاده سازی شبکه های عصبی پیچشی با KERAS

پیاده سازی شبکه های عصبی پیچشی با PyTorch

فصل پنجم:

معماری یادگیری انتقالی Transfer Learning

معرفی رویکرد یادگیری انتقالی و کاربرد آن در CNN

فصل ششم:

شبکه های عمیق بازگشتی Recurrent Neural Network

مقدماتی بر شبکه های بازگشتی

بیان ساختار سلول شبکه های بازگشتی

معرفی انواع مختلف شبکه های بازگشتی

محو شدگی و انفجار گرادیانها در شبکههای بازگشتی

معرفی شبکه بازگشتی LSTM

معرفی شبکه بازگشتی GRU

معرفی شبکه های بازگشتی دو طرفه

فصل هفتم:

معماری ترتیب به ترتیب Seq2Seq

معرفی معماری ترتیب به ترتیب و کاربرد آن در RNN

تبدیل شونده ها Transformers

معرفی رویکرد Transformers

معرفی لایه ی Attentions

معرفی مدل BERT

شبکه های عمیق Variation Autoencoders

مقدماتی بر یادگیری با ناظر و بدون ناظر

معرفی شبکه های Generative

معرفی شبکه های Auto Encoder

معرفی Variational Auto Encoder

شبکه های عمیق Generative Adversarial Networks

مقدماتی بر شبکه های عصبی Gan

معرفی شبکه های Deep Convolutional GAN

معرفی شبکه های Semisupervised GAN

معرفی شبکه های Conditional GAN

معرفی شبکه های Cycle GAN

برای این کلاس نظری ثبت نشده است.